— 为人工智能本科专业开设

2023年秋,这门课程为人工智能本科专业首次开设。

More about matrix!

欢迎选课

为什么要选这门课程?

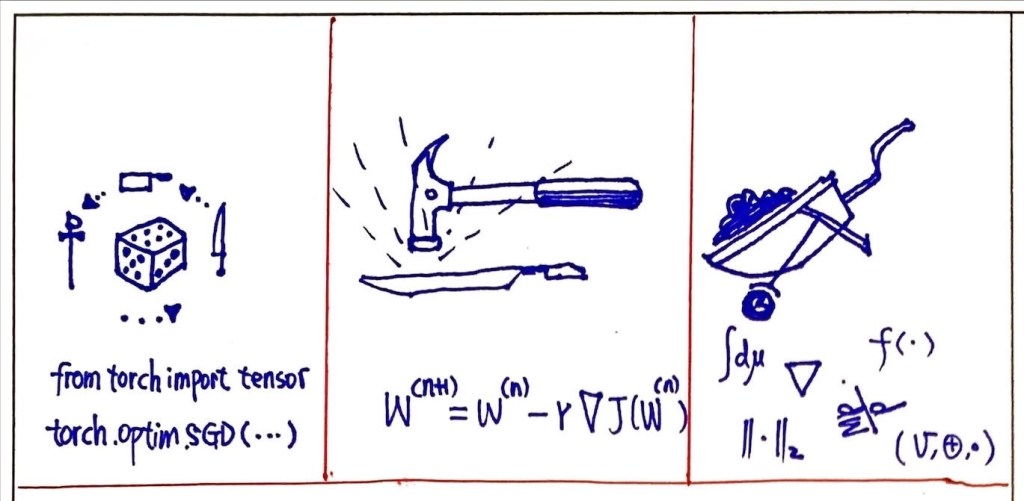

本课程讲述矩阵代数中的一些基本问题和方法,通过课程学习,讲述空间、变换、范数、矩阵分析等近现代数学元素对象和相关理论方法。借由课程学习,助学生理解代数语言下对算法模型的一般性刻画,初步了解矩阵代数在最优化、数据挖掘、机器学习等领域的应用结合,为人工智能专业高年级同学后续从事科学研究和工程实践打好理论基础。

Discover The Syllabuse

发现课程

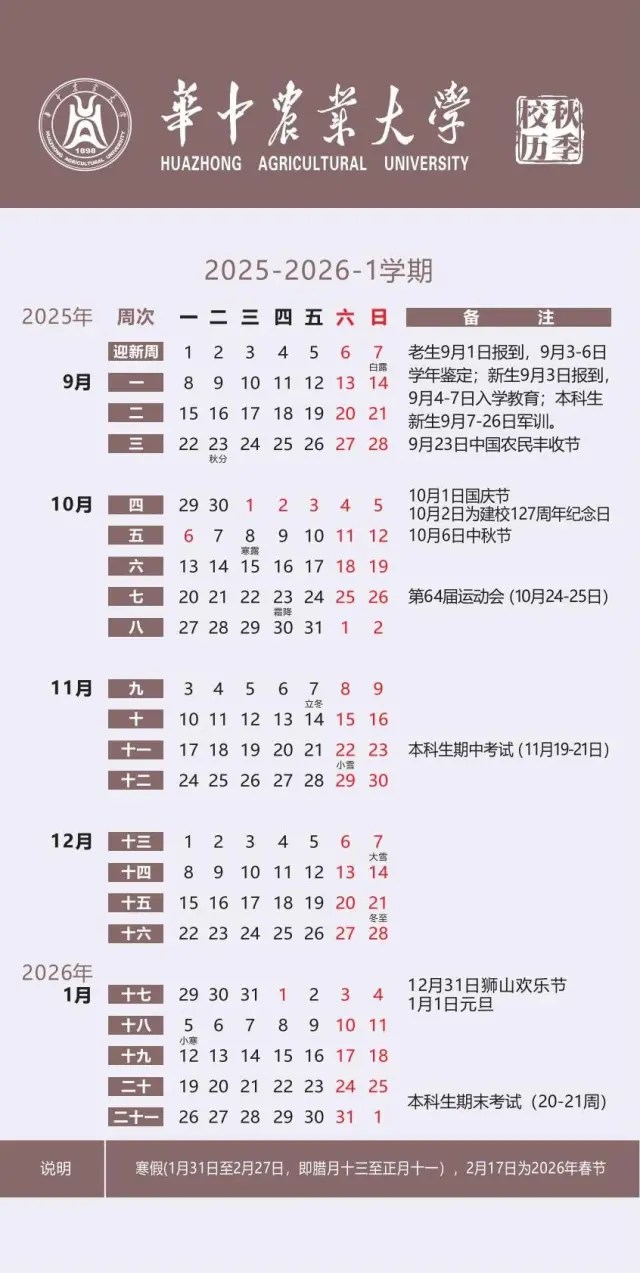

一、日程安排

| 日期 | 内容 (§x.x.x为西北工业大学《矩阵论》对应章节编号 ) |

| 13, Oct | ▩ Ch1.《线性空间与线性变换》 — — 集合与映射 (§1.1.1 ) — — 线性空间及其性质 (§1.1.2) |

| 17, Oct | ▩ Ch1.《线性空间与线性变换》 — — 线性空间的基与坐标 (§1.1.3) — — 基变换与坐标变换 (§1.1.4) |

| 24, Oct | ▩ Ch1.《线性空间与线性变换》 — — 线性子空间 (§1.1.5) — — 子空间的交与和 (§1.1.6) |

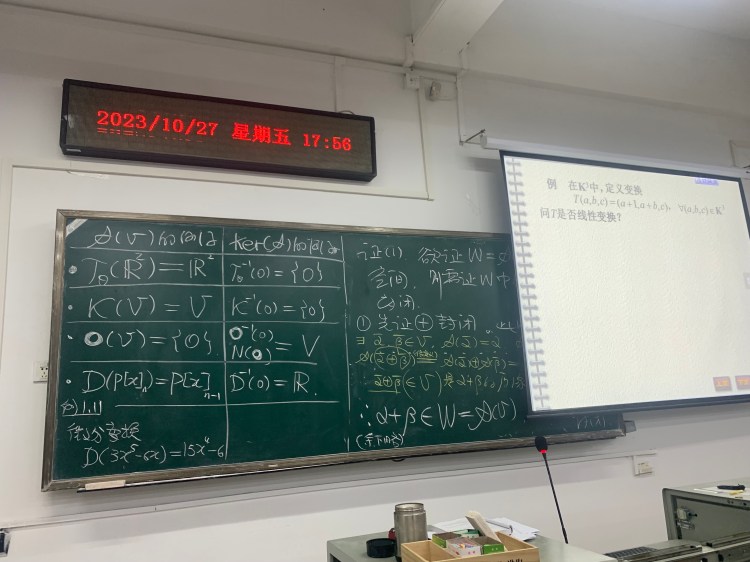

| 27, Oct | ▩ Ch1.《线性空间与线性变换》 –— — 线性变换及其运算 (§1.2.1) |

| 31, Oct | ▩ Ch1.《线性空间与线性变换》 — — 线性变换的矩阵表示 (§1.2.2) — — 专题1《从R^n到一般线性空间,从矩阵A到变换A》 ——“Rn之于一般线性空间,基之于空间,矩阵之于变换。” |

| 3, Nov | ▩ Ch1.《线性空间与线性变换》 — — 特征值与特征向量 (§1.2.3) |

| 10, Nov | ▩ Ch2. 《范数理论及其应用》 — — 向量范数的概念及Lp范数,向量序列 (§2.1.1) — — 专题2《神经网络中的Gradient计算(上)》(Slides) ——“Rn空间的Norm-ball,数列到向量序列的收敛定义一般化,Norm对逼近的刻划。” |

| 14, Nov | ▩ Ch2. 《范数理论及其应用》 — — 线性空间Rn上的向量范数的等价性 (§2.1.2) — — 矩阵范数的定义与性质 (§2.2.1) |

| 17, Nov | ▩ Ch3. 《范数理论及其应用》 — — 几种常见的矩阵范数 (§2.2.2) — — 专题3《优化问题中的范数正则项》(Slides) ——“用代数语言刻画模型,正则项的范数选取,优化问题的约束条件。“ |

| 1, Dec | ▩ Ch3. 《矩阵分析及其应用》 — — 矩阵序列 (§3.1) — — 矩阵级数 (§3.2) |

| 5, Dec | ▩ Ch3. 《矩阵分析及其应用》 — — 矩阵函数 (§3.3.1) |

| 8, Dec | ▩ Ch3. 《矩阵分析及其应用》 — — 矩阵的微分与积分 (§3.4 ) — — 专题4《神经网络中的Gradient计算(下)》(Slides) |

| 15, Dec | ▩ Ch4. 《矩阵分解》 — — Gauss消去法的矩阵形式 (§4.1.1) — — 矩阵的三角(LU)分解 (§4.1.2) |

| 19, Dec | ▩ Ch4. 《矩阵分解》 — — Givens变换 (§4.2.1) — — 矩阵的QR(正交三角)变换 (§4.2.2) |

| 22, Dec | ▩ Ch4. 《矩阵分解》 — — 矩阵的正交对角分解 (§4.4.1) — — 矩阵的奇异值与奇异值分解 (§4.4.2) — — 专题5《矩阵分解的应用》(Slides) |

| 29, Dec | ▩ 学期总结 |

二、课程考核

- 平时 50% (作业,不定期章节小测)

- 期末考试 50%

三、课程讨论进程

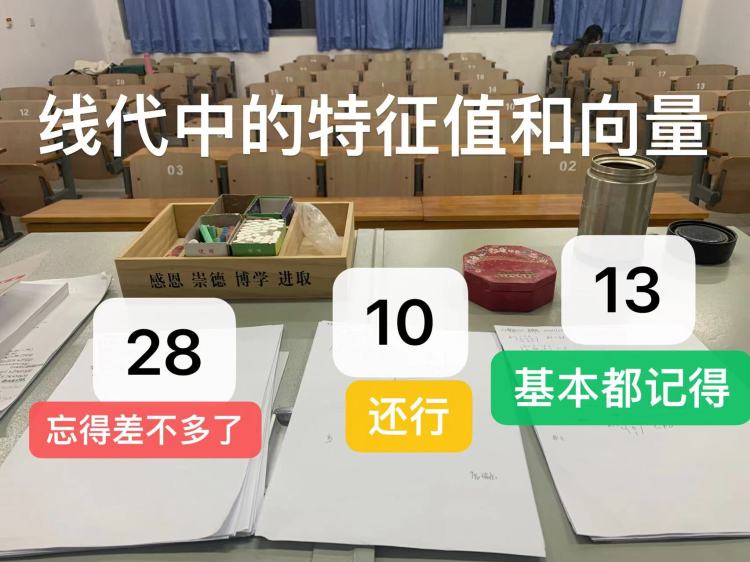

♥ 《线性空间》课程部分难度反馈

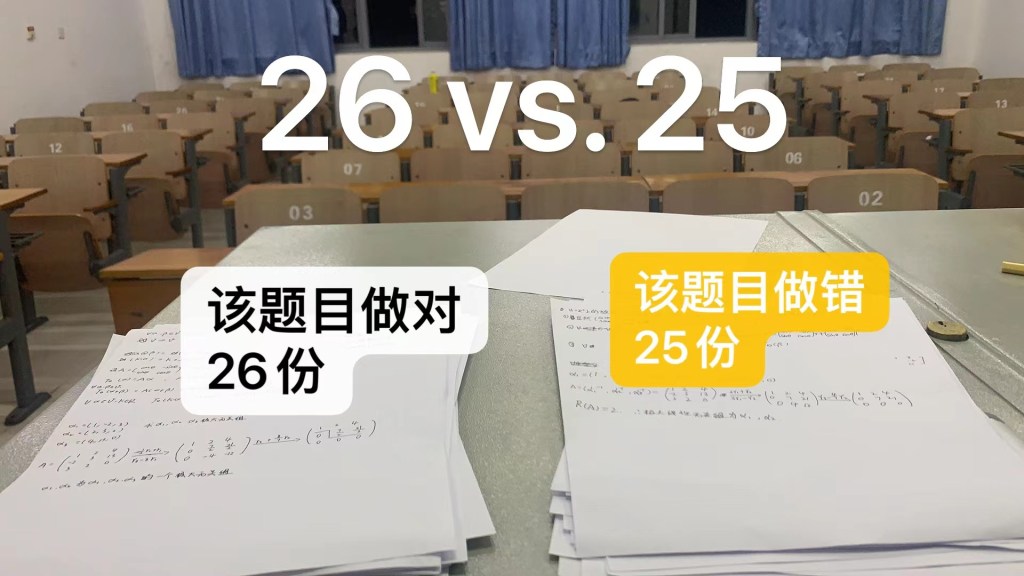

♥ 《线性空间》课堂习题训练, Oct.

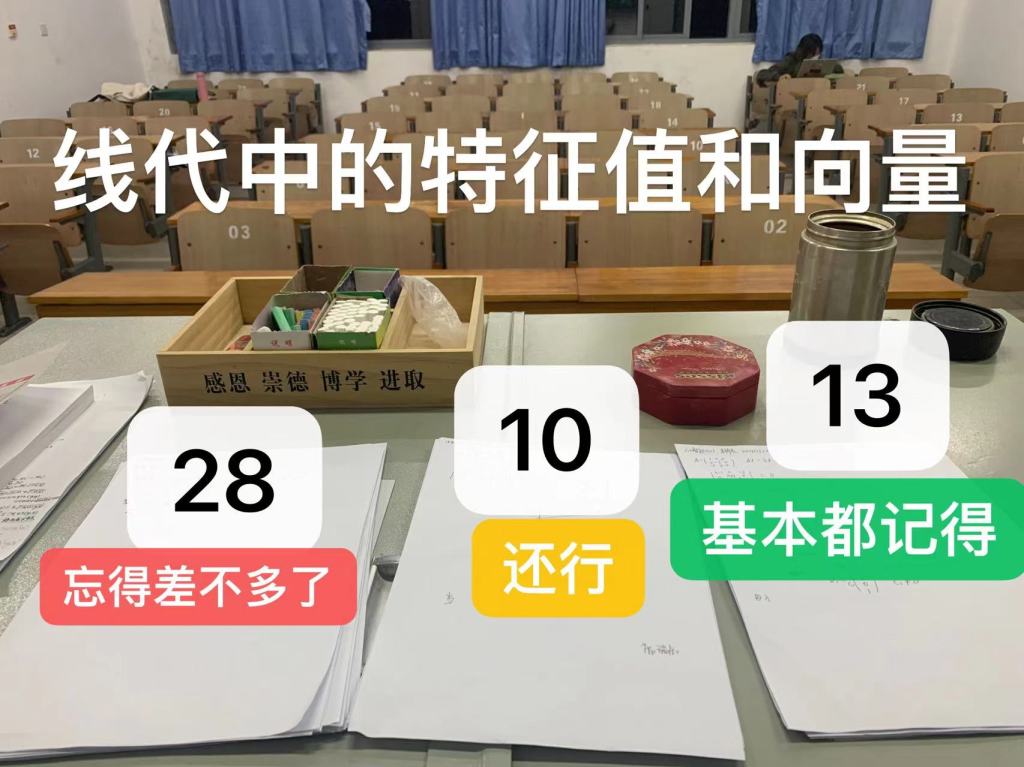

♥ 《线性变换的特征值和特征向量》课堂讲解和习题训练, Nov.

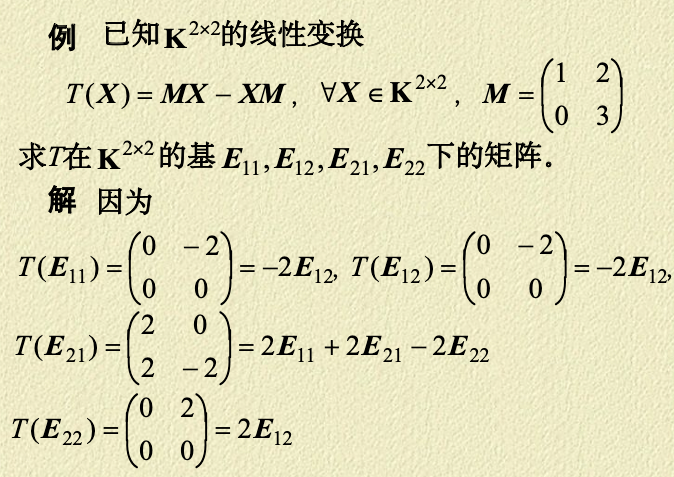

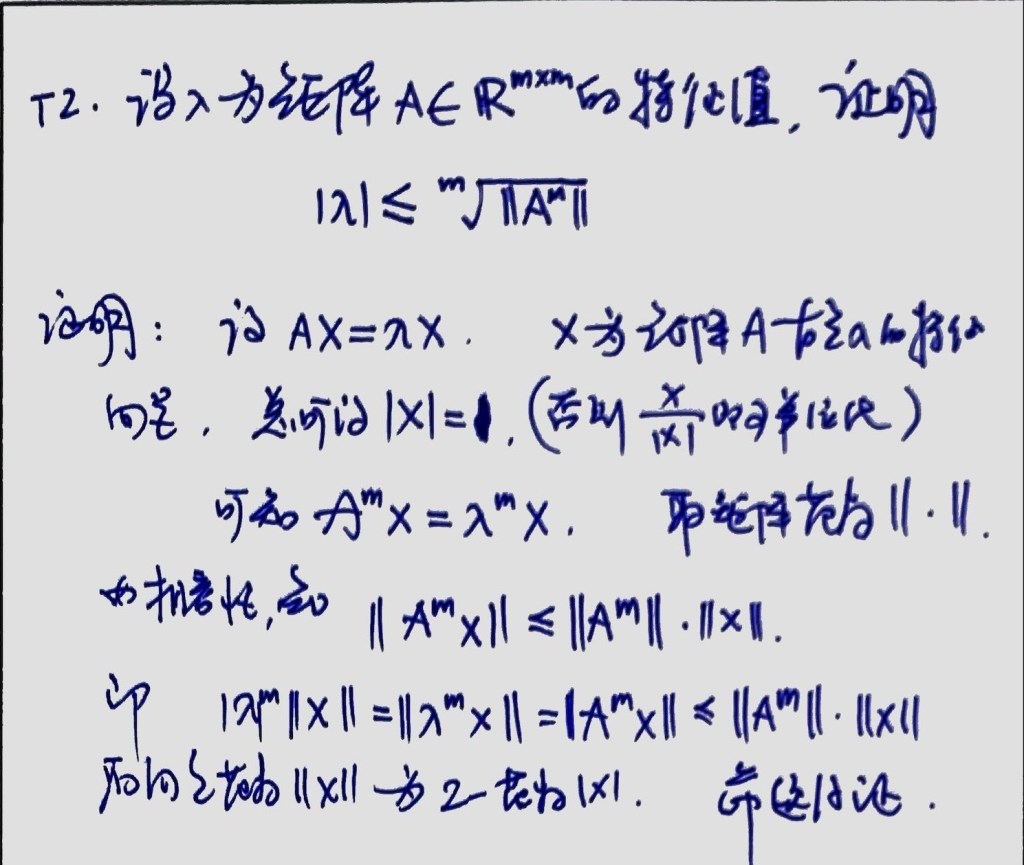

♥ 《线性变换的特征值和特征向量》讲义摘拍, Nov.

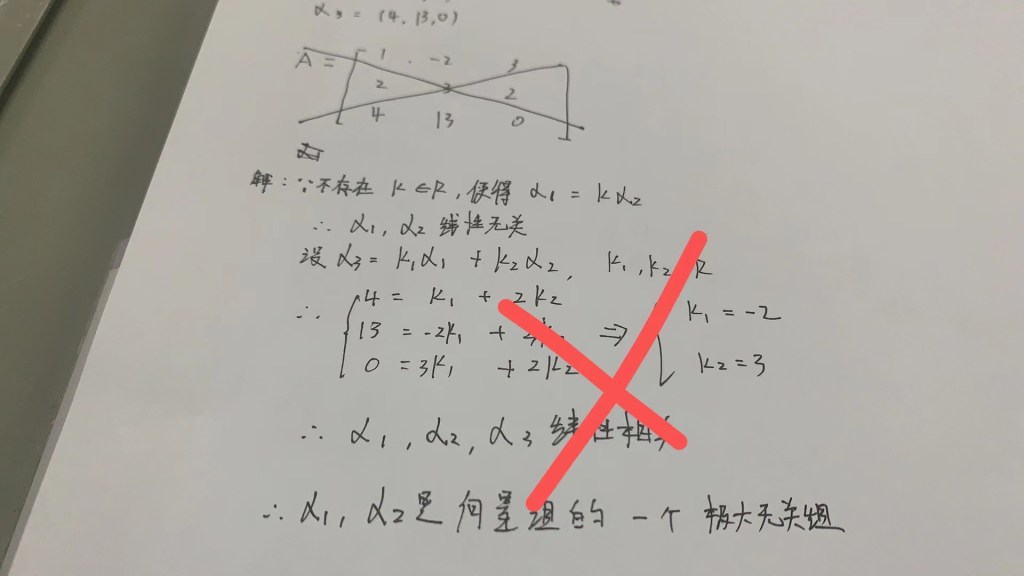

♥ 《线性空间和线性变换》作业摘拍, Nov. (摘自李蔓林、刘家盛、常振辊、方张雨晨、吕文惠、和朱金等同学的作业)

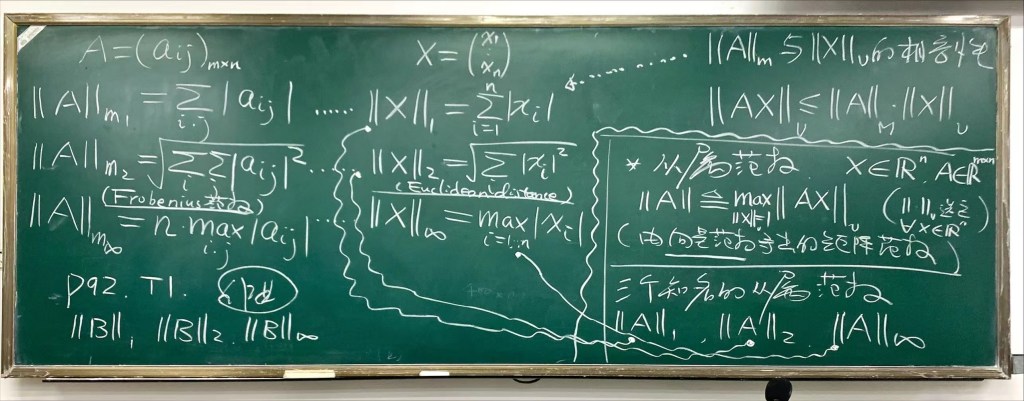

♥ 《范数》习题, Nov.

♥ 《矩阵序列和收敛矩阵》讲义摘拍, Dec.

♥ 《矩阵级数》讲义摘拍, Dec.

♥ 《矩阵微分》讲义摘拍, Dec.

♥ 《矩阵分解》讲义摘拍, Dec.

♥ 《范数/矩阵分析》课后习题讲解——讲义摘拍, Dec.

♥ 课堂掠影

Course Resources and External Links

课程资源和外部链接

四、推荐文献-课外阅读

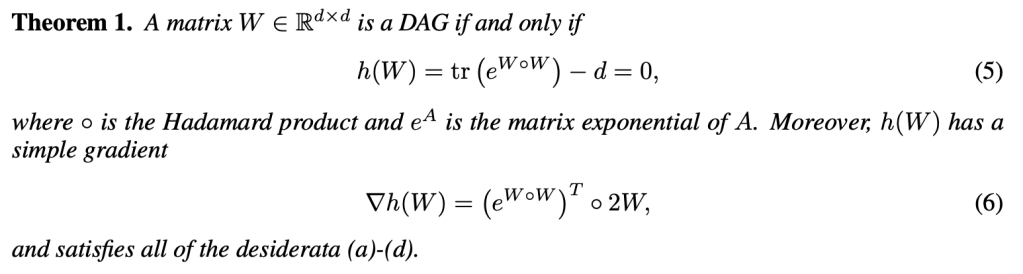

☁ 1. 扩展阅读——矩阵函数在建模中的典型应用——以一篇因果推断论文为例。(矩阵函数用以统计通路数量——请联系《离散数学》图论部分相关结论)

Zheng, Xun, et al. “DAGs with no tears: Continuous optimization for structure learning.” Advances in neural information processing systems 31 (2018). (Link)

☁ 2. 扩展阅读——矩阵分解论文。Daniel D. Lee & H. Sebastian Seung (1999). “Learning the parts of objects by non-negative matrix factorization”. Nature. 401 (6755): 788–791. (Link)

所有课程

♥ 回到 我的课程列表和逻辑关系图

Find us!

找到我们!

课后答疑

办公室: 逸夫楼C610

助教:唐子铭

Course for BioNLP

学科交叉,融会贯通,学好BioNLP.

Course Hours

See jw.hzau.edu.cn

Office

C610, Yifu bldg

Contact me

xiajingbo.math@gmail.com